一文详解:DeepSeek 第四天开源的模型设计套件

一文详解:DeepSeek 第四天开源的模型设计套件第四天,DeepSee发布包括三个主要项目: DualPipe- 一种用于 V3/R1 训练的双向流水线并行算法,实现计算和通信完全重叠; EPLB(Expert Parallelism Load Balancer) - 专为 V3/R1 设计的专家并行负载均衡器; Profile-data- 分析 V3/R1 中计算与通信重叠的性能数据集。

第四天,DeepSee发布包括三个主要项目: DualPipe- 一种用于 V3/R1 训练的双向流水线并行算法,实现计算和通信完全重叠; EPLB(Expert Parallelism Load Balancer) - 专为 V3/R1 设计的专家并行负载均衡器; Profile-data- 分析 V3/R1 中计算与通信重叠的性能数据集。

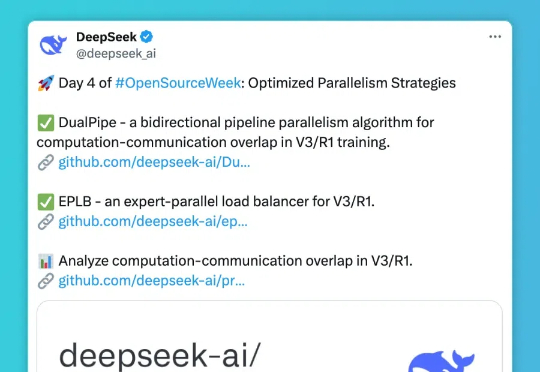

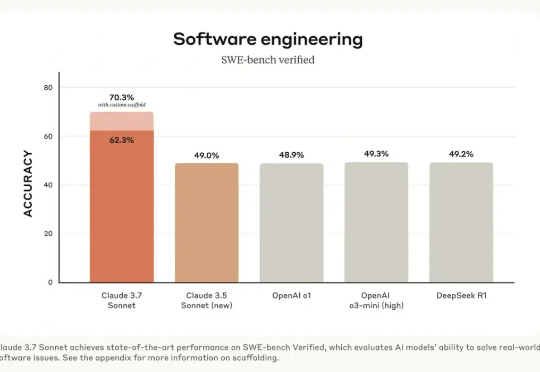

昨天,Claude 3.7 Sonnet 正式发布。根据目前的各项测评,这个模型可以说是全宇宙最好的代码生成模型,超越了 DeepSeek R1 和 OpenAI 的 o3 等模型。如果你是程序员,一定要第一时间切换过去,用下这款模型。

上周末,一则来自北京某医院神经外科主任医师的视频引发关注。据这位医师介绍,他曾用 DeepSeek 协助诊断了一位超复杂脑瘤患者的病情,并给出了超高评价:“对于这种较为深入的医学问题,DeepSeek 至少展现出了与省级三甲医院专家相当的水平。”

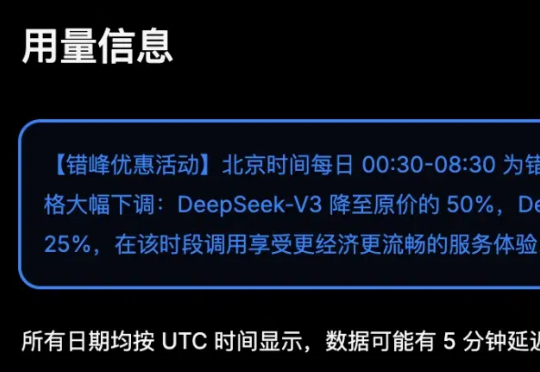

即日起,北京时间每日00:30-08:30为错峰时段,API 调用价格大幅下调:DeepSeek-V3 降至原价的50%,DeepSeek-R1降至25%,在该时段调用享受更经济更流畅的服务体验。具体价格参看图2.

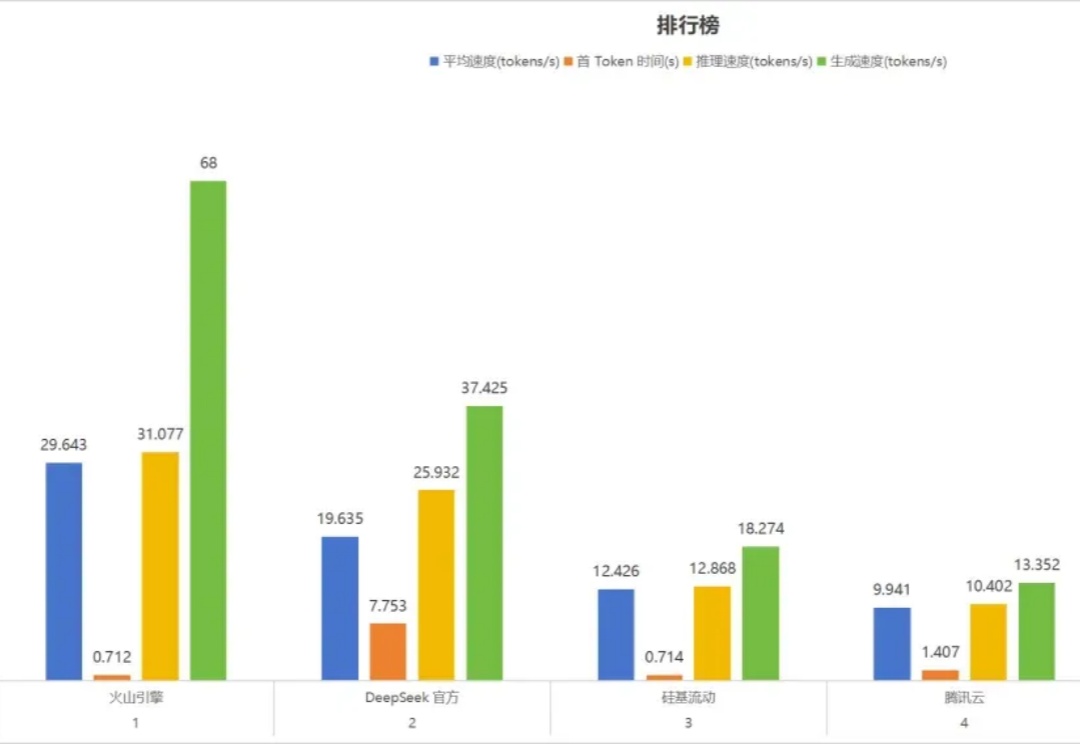

部署 DeepSeek 系列模型,尤其是推理模型 DeepSeek-R1,已经成为一股不可忽视的潮流。

这一波 DeepSeek 的泼天流量,各种大小公司都在吃。为什么,一夜之间,所有产品都在宣传自家接入了 DeepSeek 呢?主要原因是 DeepSeek 官网无法满足全世界人民日益增长的 DeepSeek 使用需求。

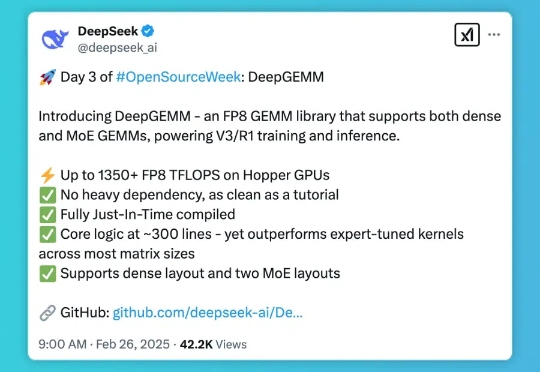

DeepSeek 的开源周已经进行到了第三天(前两天报道见文末「相关阅读」)。今天开源的项目名叫 DeepGEMM,是一款支持密集型和专家混合(MoE)GEMM 的 FP8 GEMM 库,为 V3/R1 的训练和推理提供了支持,在 Hopper GPU 上可以达到 1350+ FP8 TFLOPS 的计算性能。

DeepSeek 开源周的第三天,带来了专为 Hopper 架构 GPU 优化的矩阵乘法库 — DeepGEMM。这一库支持标准矩阵计算和混合专家模型(MoE)计算,为 DeepSeek-V3/R1 的训练和推理提供强大支持,在 Hopper GPU 上达到 1350+FP8 TFLOPS 的高性能。

DeepSeek崛起,ChatGPT在美国高校如何稳占C位?

DeepSeek席卷校园:头部高校开AI大课。